- Neguentropía

-

La neguentropía o negentropía, también llamada entropía negativa o sintropía, de un sistema vivo, es la entropía que el sistema exporta para mantener su entropía baja; se encuentra en la intersección de la entropía y la vida.

La neguentropía se puede definir como la tendencia natural de que un sistema se modifique según su estructura y se plasme en los niveles que poseen los subsistemas dentro del mismo. Por ejemplo: las plantas y su fruto, ya que dependen los dos para lograr el método de neguentropía.

Contenido

Concepto de entropía negativa

El concepto de “entropía negativa” fue introducido por Erwin Schrödinger (físico teórico, y uno de los padres de la mecánica cuántica) en su libro de ciencia popular what is life?, publicado en 1943. Más tarde, Léon Brillouin cambio la palabra a negentropia, para expresarla en una forma mucho más “positiva”, diciendo que un sistema vivo importa negentropia y la almacena. En 1974, Albert SzentGyörgyi (Nobel de Fisiología Médica en 1937) propuso cambiar el término de negentropia a sintropia, aunque este último ya había sido usado por el matemático Luigi Fantappiè, quien lo usó con el fin de construir una teoría unificando la física y la biología. Buckminster Fuller, ingeniero, arquitecto y diseñador del siglo XX, trato de hacer popular este término, pero la palabra negentropia siempre permaneció como la común.

En el año 2009, Mahulikar & Herwig redefinieron la negentropía de un sub-sistema ordenado dinámicamente como el déficit de entropía relacionado al caos que rodea el sub-sistema ordenado. De esta forma, las unidades de la negentropia son [J/kg-K] cuando se define con base en la entropía por unidad de masa, mientras que cuando se define con base en la entropía por unidad de energía las unidades son [K-1]. Esta definición ha habilitado:

- Representaciones termodinámicas a escala invariante de la existencia de un orden dinámico,

- pensamiento de principios físicos exclusivamente para la existencia de un orden dinámico y evolución, y

- la interpretación matemática de la negentropia de Schrödinger.

Contrastes

Así como la entropía establece que la energía y cualquiera de sus formas de manifestarse (ya sea en forma de materia, de plasma o radiación) tiende a buscar un estado de equilibrio inexpresivo continuo, la neguentropía define la energía como una serie de causas y efectos armónicamente acomodadas en las que la suma total de los efectos armónicos dan como resultado un acople de mayor magnitud que el original, siendo una forma de resonancia que da como resultado paquetes de energía perfectamente utilizables por cualquier sistema perceptor de sus efectos.

Teoría de la información

En la teoría de la información y la estadística, la negentropia se usa como medida de distancia de normalidad. Si se considera una señal con una cierta distribución, y la señal es gausiana, esta tendrá una distribución normal. La negentropia es siempre positiva, invariante a cambios de coordenadas lineales, y se desvanece si y solo si la señal es gausiana.

La negentropía se define por:

Donde S(Φχ) es el diferencial de entropía de la densidad gausiana con la misma media y varianza, mientras que pχ y S(pχ) es la entropía diferencial de pχ:

La negentropía se usa es estadística y procesamiento de señales. Está relacionada a la entropía de redes, que es usada en análisis de componentes independientes. La negentropía puede ser entendida intuitivamente como la información que puede ser guardada cuando se representa pχ de forma eficiente: si pχ fuera una variable aleatoria (con distribución gausiana) con misma media y varianza, se necesitaría una máxima longitud de datos para ser representada, aun en su forma más eficiente. Como pχ no es tan aleatorio, algo se sabe de antemano. pχ contiene menos información desconocida, y necesita menos longitud de datos para ser representado de forma más eficiente.

Correlación entre negentropía estadística y energía libre de Gibbs

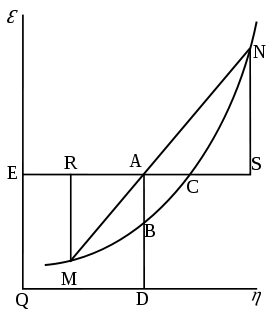

Gráfica de energía libre de Gibbs (Willard Gibbs en 1873), la cual muestra un plano perpendicular al eje de v (volumen) y pasando por el punto A, que representa el estado inicial del cuerpo. MN es la sección de la superficie de la energía disipada. Qε y Qη son secciones de los planos η = 0 y ε = 0, y por tanto paralelos a los ejes de ε (energía interna) y η (entropía) respectivamente. AD y AE son la energía y entropía del cuerpo en su estado inicial. En AB y AC, su energía disponible (energía libre de Gibbs) y su capacidad de entropía (la cantidad por la cual la entropía del cuerpo puede aumentar sin cambiar la energía del cuerpo o aumentar su volumen) respectivamente.

Gráfica de energía libre de Gibbs (Willard Gibbs en 1873), la cual muestra un plano perpendicular al eje de v (volumen) y pasando por el punto A, que representa el estado inicial del cuerpo. MN es la sección de la superficie de la energía disipada. Qε y Qη son secciones de los planos η = 0 y ε = 0, y por tanto paralelos a los ejes de ε (energía interna) y η (entropía) respectivamente. AD y AE son la energía y entropía del cuerpo en su estado inicial. En AB y AC, su energía disponible (energía libre de Gibbs) y su capacidad de entropía (la cantidad por la cual la entropía del cuerpo puede aumentar sin cambiar la energía del cuerpo o aumentar su volumen) respectivamente.

Existe una magnitud física estrechamente vinculada a la energía libre (entalpia libre), con una unidad de entropía isomórfica a la negentropía, conocida en estadística y en teoría de la información. En 1873 Willard Gibbs creó un diagrama ilustrando el concepto de energía libre correspondiente a entalpia libre. En el diagrama se puede ver la cantidad llamada capacidad de la entropía. Dicha cantidad es la entropía que se puede incrementar sin cambiar la energía interna o aumentar el volumen. En otras palabras, se trata de una diferencia entre el máximo posible, en condiciones de asumir, la entropía y la entropía real. Esto corresponde exactamente a la definición de negentropía adoptada por la estadística y la teoría de la información. Una cantidad física similar fue presentada en 1869 por Massieu para el proceso isotérmico, y luego por Max Planck para el proceso isotérmico-isobárico. Más adelante, el potencial termodinámico de Massieu-Planck, conocido también como entropía libre, ha mostrado jugar un rol importante en la formulación entrópica de la mecánica estadística, con aplicaciones en biología molecular y en procesos termodinámicos no equilibrados.

-

- Donde:

- J - (“Capacidad para entropía” de Gibbs)

- Φ – Potencial de Massieu

- Z - Funcion de particion

- k - Constante de Boltzman

Teoría de la organización

En 1988, basándose en la definición de entropía estadística de Shannon, Mario Ludovico dio una definición formal al termino sintropia, como una medida del grado de organización interna de cualquier sistema formado por componentes que interactúan entre si. De acuerdo a esta definición, la sintropía es una cantidad complementaria a la entropía. La suma de dos cantidades define un valor constante, específicas del sistema en el que ese valor constante identifica el potencial de transformación. Usando estas definiciones, la teoría desarrolla ecuaciones aptas para describir y simular cualquier posible forma de evolución del sistema, ya sea hacia niveles mayores o menores de “organización interna” (por ejemplo la sintropia), o hacia el colapso del sistema.

La organización como sistema (abierto) esta constituido por los elementos básicos de este (entradas, medio, salidas y retroalimentación) y es en las entradas donde la información juega un papel clave como medio regulador, medio neguentrópico, ya que a través de ella se puede disminuir la cantidad de incertidumbre (entropía). Se puede considerar a la información como elemento generador de orden y como herramienta fundamental para la toma de decisiones en la organización o en cualquier sistema en el que se presenten situaciones de elección con múltiples alternativas.

En la gestión de riesgos, negentropía es la fuerza que tiene por objeto lograr un comportamiento organizacional eficaz y conducir a un estado estacionario predecible.

Véase también

Bibliografía

- Luz Amanda Camacho: Teoría general de sistemas.

- Johansen O.: Las comunicaciones y la conducta organizacional.

- Juan Vergara: Gestión por Procesos ITM.

Enlaces externos

Categorías:- Teoría de sistemas

- Teoría de la información

- Entropía termodinámica

- Entropía de la información

Wikimedia foundation. 2010.